この記事は会員限定です。会員登録(無料)すると全てご覧いただけます。

前回の記事ではAI開発中に内在する代表的なバイアスやリスクを整理した。解説したリスクはどれも重大な損失につながる可能性があるため、AIがもたらす効果とAI倫理を整理した上で、実現するAIの構築が必要だ。一方で「これさえ押さえれば倫理的なAIの出来上がり」という解決法はない。AI技術者は、数ある手法群から状況に適した技術を選定し、活用しやすいAIの構築を目指していくことが求められる。

今回は、前回整理したデータ収集の際に起きてしまいがちなバイアスの発生を防ぐために、AI構築に携わる技術者がどのように対応すべきか、具体的な方法を解説する。

データ収集段階でのバイアスへの対処法

1.データが含む社会的偏見を公平性(Fairness)に配慮したAIで是正する

AIモデル学習に用いるデータセットが、人種や民族、性別などによる偏見やギャップの影響を受けている場合には、それに基づくAIモデルも容易に影響を受けてしまう。データが含む偏見やギャップを忠実に再現してしまうこともあるだろう。そのような課題を解決するには、単に、人種、民族、性別といったセンシティブな属性をモデルに学習させない、というだけでは不十分だ。

なぜなら、センシティブな属性と関連する特徴量をAIが学習することで、間接的にセンシティブ情報がAIモデルの予測結果に影響を与えてしまうからだ。この現象は「Red-Lining効果」と呼ばれる。過去に米国で、低所得層の特定人種が居住する地域に対して、金融機関が融資を避けるという差別が発生した。その際、黒人居住区を地図上に赤線で囲っていたことがこの現象の名前の由来だ。この場合、適切な対策を講じないと人種に基づく偏見と居住地データが間接的にひも付いているため、居住地データを用いてAIモデルを構築してしまうと人種に基づく偏見を持ったAIが構築されてしまう。

では、どのように対処すればよいだろうか。AIモデルにおいて差別や偏見を取り除くためには、まず差別や偏見がない公平な状況を定義することから始めることが必要だ。

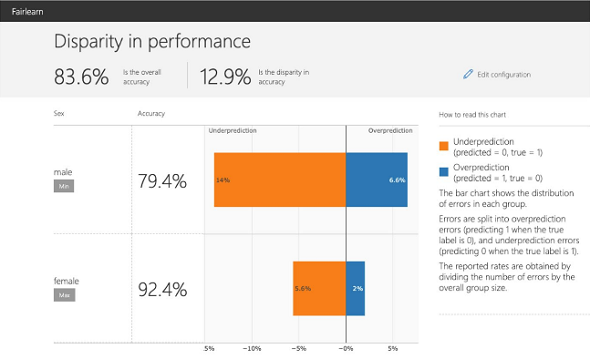

以下の図は公平ではないAIモデルの予測精度を示している。センシティブ属性に依存してAIモデルの予測値が変わらないといったような状態は、公平な状況といえるだろう。しかし、性別によって正答率が10%以上変わってしまっているため、正答率で比較するとAIモデルによる予測が性別によって不公平な状況となっている。

公平性ツールの一つであるMicrosoft「Fairlearn」 の評価ダッシュボード例(出典:Fairlearn v0.5.0)

公平性ツールの一つであるMicrosoft「Fairlearn」 の評価ダッシュボード例(出典:Fairlearn v0.5.0)公平ではないAIモデルの分かりやすい例を紹介したところで、改めてAIにおける「公平性」とは何かについて掘り下げたい。対象とする問題や状況も考慮すべき要素ではあるが、ここでは代表的な集団公平性の定義である「民主的公平性(Demographic Parity)」と「均等オッズ(Equalized Odds)」について解説をする。

簡単に説明するため、センシティブな特徴を2値変数のS∈{0,1}とし、Y∈{0,1}を予測する2値の分類問題対象に説明する。

予測値を

とすると、民主的公平性は、以下のように表される。

これはセンシティブ属性にかかわらず、AIモデルにより推定された確率

が不変であるという定義となる。つまり、民主的公平性を保持できていたとすると、人種や性別といったセンシティブ属性によって予測スコアの分布が変わらないことになるので、その意味で公平なAIといえる。

一方、民主的公平性は本来の目的変数の分布を無視していることから逆差別につながりやすい指標ともいえる。それらの問題を解決する、AIにおける集団的公平性定義が、均等オッズだ。均等オッズは、以下のように表される。

一見難解であるが、これはy=1の場合、左辺と右辺はともに真陽性率(True Positive Rate)を表しており、センシティブ属性ごとに真陽性率が変わらないことを示している。また、y=0の場合には偽陽性率(False Positive Rate)がセンシティブ変数によらず均等であるという定義となる。つまり、センシティブ属性によって、真陽性率、偽陽性率といった精度の違いが存在しないことが定義となっている。

その他にも均等オッズをy=1のみの場合に限定した「Equal Opportunity」という公平性の定義も存在する。機械学習において、y=1の場合に治療や採用など、機会が与えられることが多いことに由来しており、特定クラスに対する公平性を担保したい場合に有用な定義である。こうした公平性の定義に関してもAIを構築する際には、適切な公平性の定義を選択していく必要がある。

ここまで公平なAIを実現するための指針となる定義を解説した。次にその定義を直接または間接的に実現するアプローチについて紹介する。

選択した指標に沿って公平なAIを実現するためには、a.学習前にデータセットをより公平にする「Pre-Processing」、b.公平な学習をAIモデル内部の学習アルゴリズムで行う「In-Processing」、c.学習したAIモデルの予測値やモデルアウトプットを補正する「Post-Processing」の3つのアプローチが存在する。

a.学習前に公平な状態を目指すPre-Processing

Pre-Processingは、モデル学習前に、より公平な状態を目指すアプローチだ。例えば、センシティブ属性と相関性が高い特徴量を除くのも1つの手法だ。センシティブ属性と関係が強い特徴量を除去することで、センシティブ属性と目的変数の暗黙的な相関を緩和することができる。

関連記事

Copyright © ITmedia, Inc. All Rights Reserved.

からの記事と詳細 ( AIがもたらす「不公平な結果」を防ぐために開発者は何を考慮すればよいのか - ITmedia )

https://ift.tt/yx5EbMA

No comments:

Post a Comment